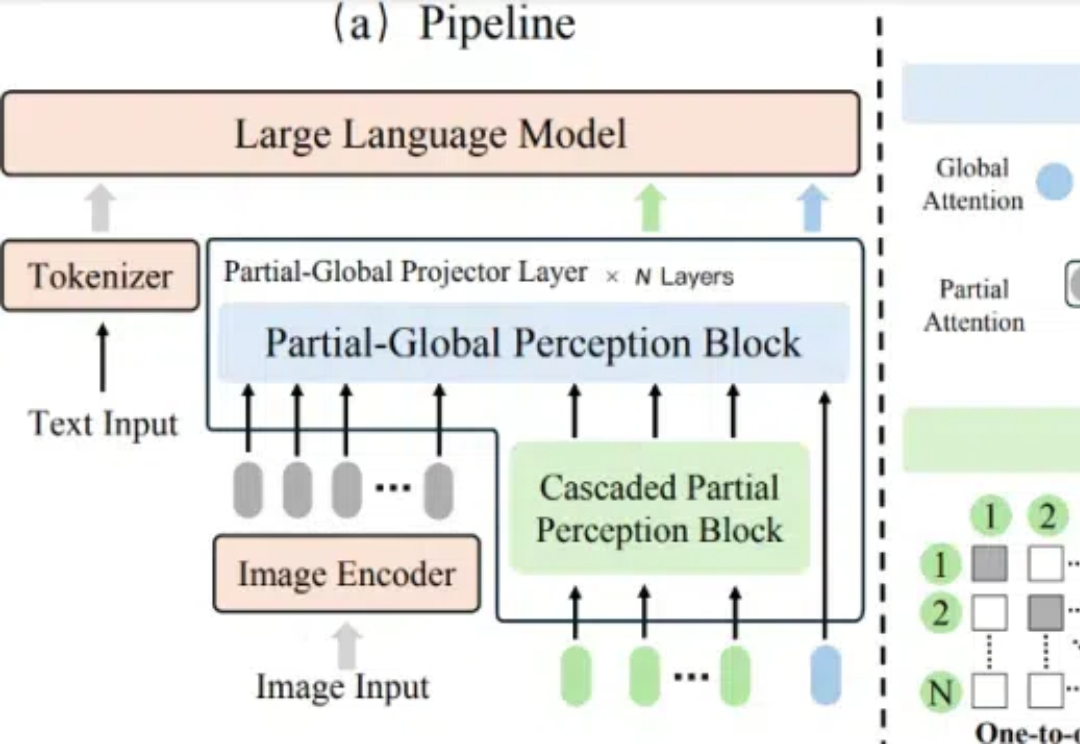

如何高效桥接视觉和语言,字节&中大提出全新多模态大模型连接器ParGo

如何高效桥接视觉和语言,字节&中大提出全新多模态大模型连接器ParGo在多模态大语言模型(MLLMs)的发展中,视觉 - 语言连接器作为将视觉特征映射到 LLM 语言空间的关键组件,起到了桥梁作用。

在多模态大语言模型(MLLMs)的发展中,视觉 - 语言连接器作为将视觉特征映射到 LLM 语言空间的关键组件,起到了桥梁作用。

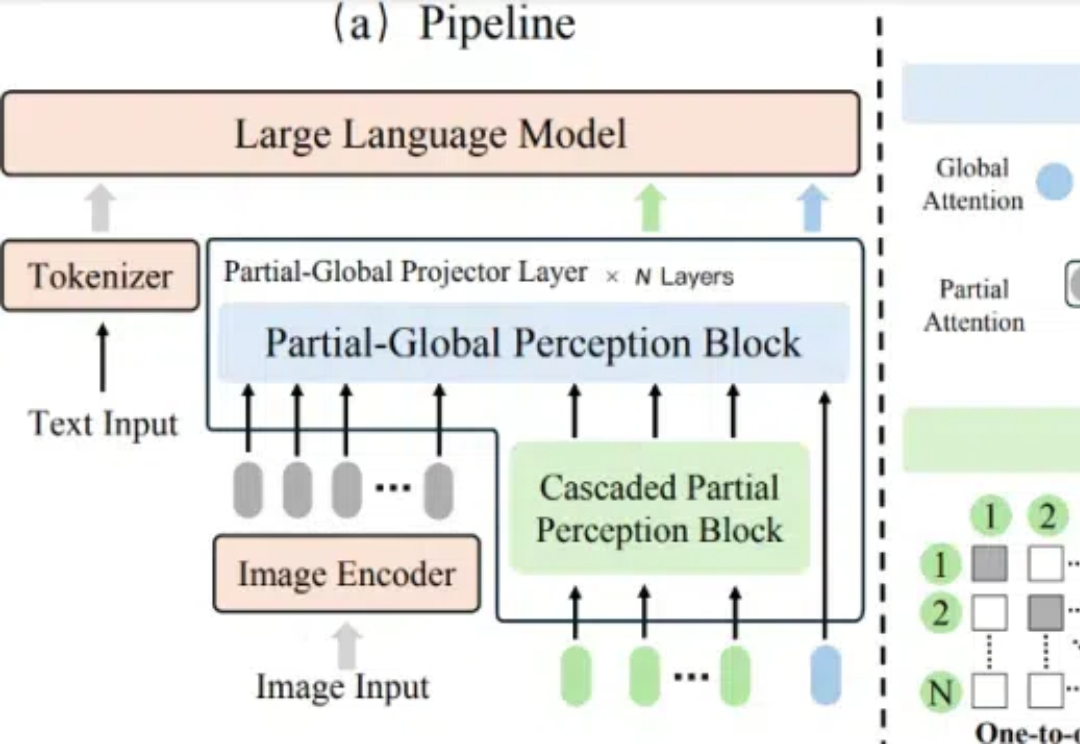

发表于昨天的论文《Agent Laboratory: Using LLM Agents as Research Assistants》对于科研界具有划时代意义,过去几周才能完成的科研任务现在仅需20分钟到一两个小时左右(不同LLM),花费2-13个美金的Token即可完成!

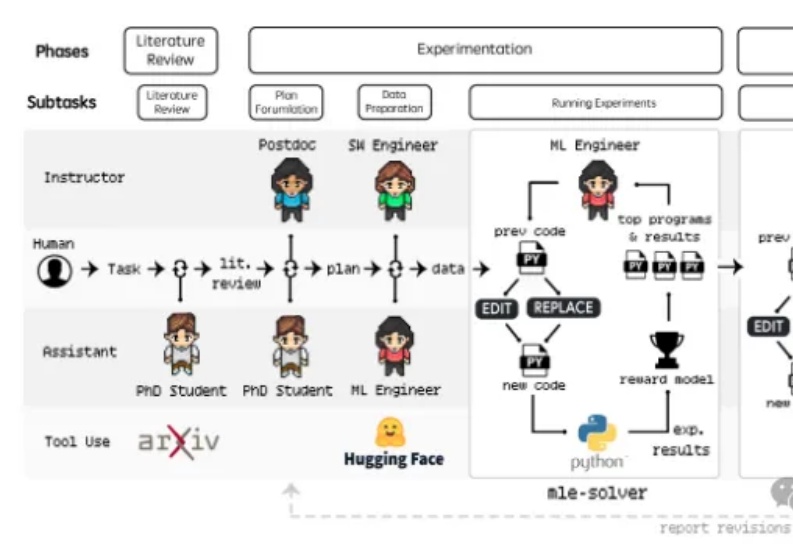

在 LLM 落地场景中,医疗领域的应用开始展现出比较高的确定性,尤其是 AI scribe 产品能解决临床文档记录枯燥、耗时这一行业痛点。Abridge 是其中最有代表性的公司,训练了专用于临床文档的 ASR 和文本生成模型,能够替代 90% 左右的人工工作量。

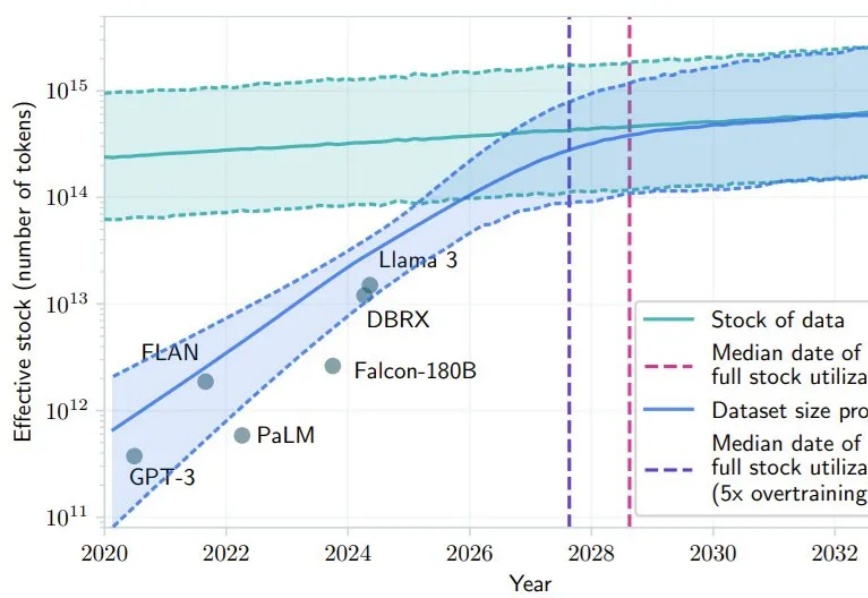

最近 AI 社区很多人都在讨论 Scaling Law 是否撞墙的问题。其中,一个支持 Scaling Law 撞墙论的理由是 AI 几乎已经快要耗尽已有的高质量数据,比如有一项研究就预计,如果 LLM 保持现在的发展势头,到 2028 年左右,已有的数据储量将被全部利用完。

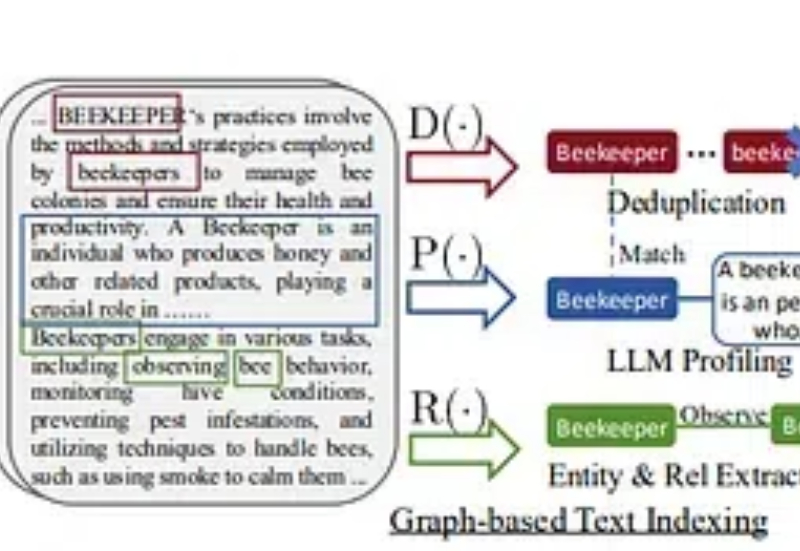

在这个故事中,我将提供一个快速教程,展示如何使用浏览器使用、LightRAG和本地LLM创建一个强大的聊天机器人,以开发一个能够抓取您选择的任何网站的AI代理。此外,您可以询问有关您的数据的问题,这将为您提供该问题的回答。

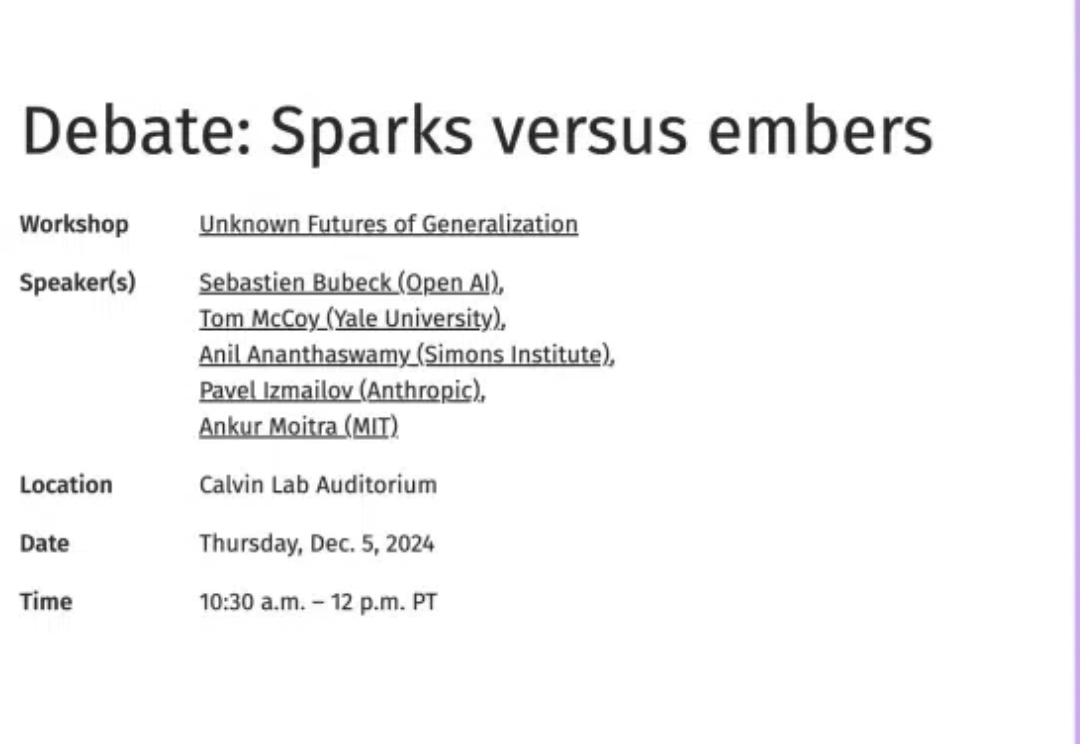

本月,OpenAI科学家就当前LLM的scaling方法论能否实现AGI话题展开深入辩论,认为将来AI至少与人类平分秋色;LLM scaling目前的问题可以通过后训练、强化学习、合成数据、智能体协作等方法得到解决;按现在的趋势估计,明年LLM就能赢得IMO金牌。

2023年6月,理想汽车推出了自研认知大模型“Mind GPT”,它以“理想同学”App的形式出现在理想汽车的车机中,支持通过自然语言交流、发送指令。2024年,Mind GPT升级到3.0,带来了行业领先的自然语言任务执行功能。

最近,类 o1 模型的出现,验证了长思维链 (CoT) 在数学和编码等推理任务中的有效性。在长思考(long thought)的帮助下,LLM 倾向于探索、反思和自我改进推理过程,以获得更准确的答案。

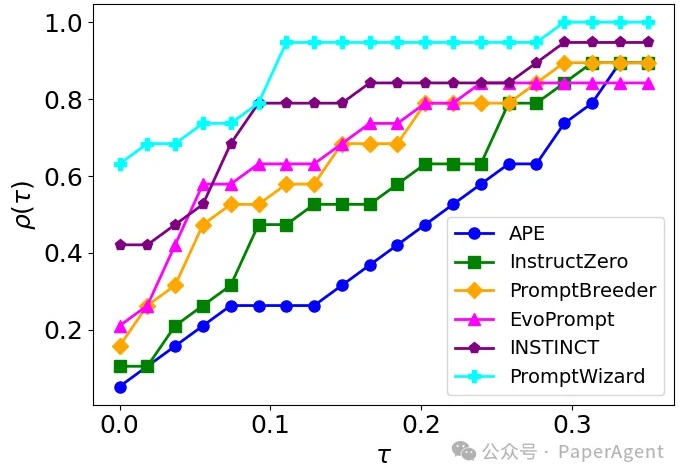

PromptWizard (PW) 旨在自动化和简化提示优化。它将 LLM 的迭代反馈与高效的探索和改进技术相结合,在几分钟内创建高效的prompts。

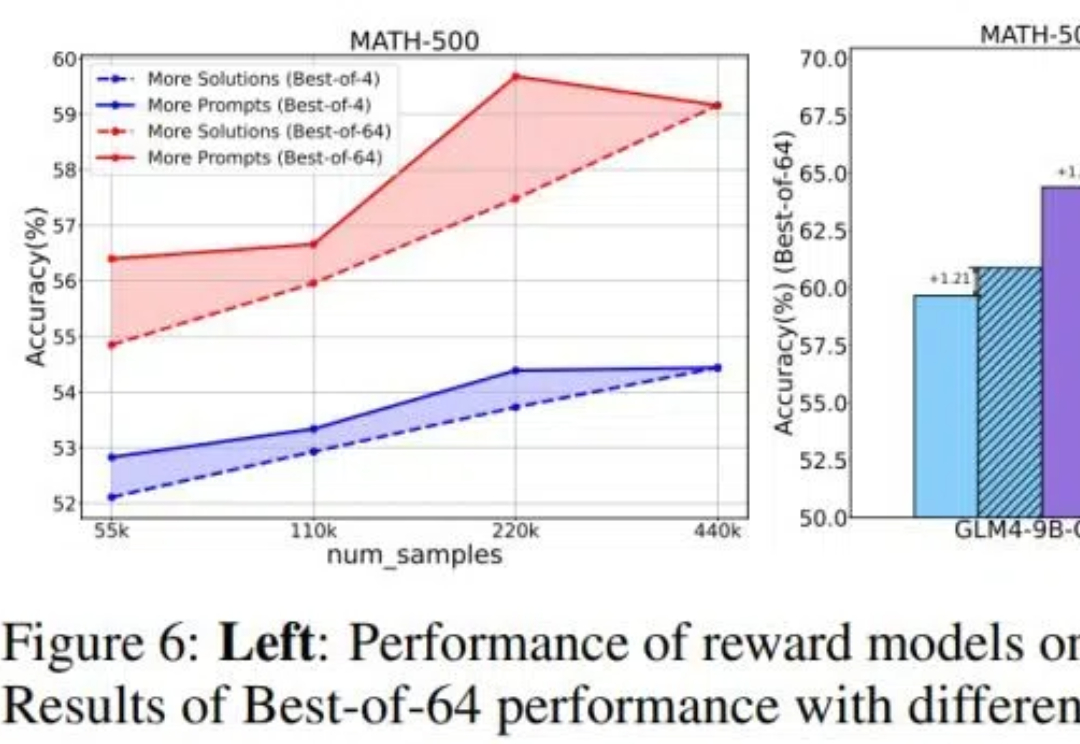

目前关于 RLHF 的 scaling(扩展)潜力研究仍然相对缺乏,尤其是在模型大小、数据组成和推理预算等关键因素上的影响尚未被系统性探索。 针对这一问题,来自清华大学与智谱的研究团队对 RLHF 在 LLM 中的 scaling 性能进行了全面研究,并提出了优化策略。